Book traversal links for A Educação em Exame

Não há mãe, pai, político, comentador, especialista que não tenha uma ligação ao sistema educativo ou uma opinião acerca dele. Todos fomos alunos ou todos conhecemos alguém que o seja.

Mas nem sempre abundaram os dados e as análises que nos ajudassem a ir além do senso-comum ou da mera opinião. A partir de 2000, o PISA (Programme for International Student Assessment) permite tirar a fotografia aos sistemas educativos, revelar sucessos e expor fraquezas.

Chamam-lhe o maior teste do mundo e não é por acaso. São 79 os países e economias que participam naquela que é a maior avaliação feita nesta área, realizada de três em três anos, envolvendo cerca de 600 mil alunos de 15 anos, de países da OCDE e não só. Mas ao contrário dos outros testes a pressão não recai sobre os alunos. Porque no final a nota é dada aos sistemas educativos, aos governantes e às suas políticas. E, para o bem ou para o mal, o mundo inteiro fica a saber.

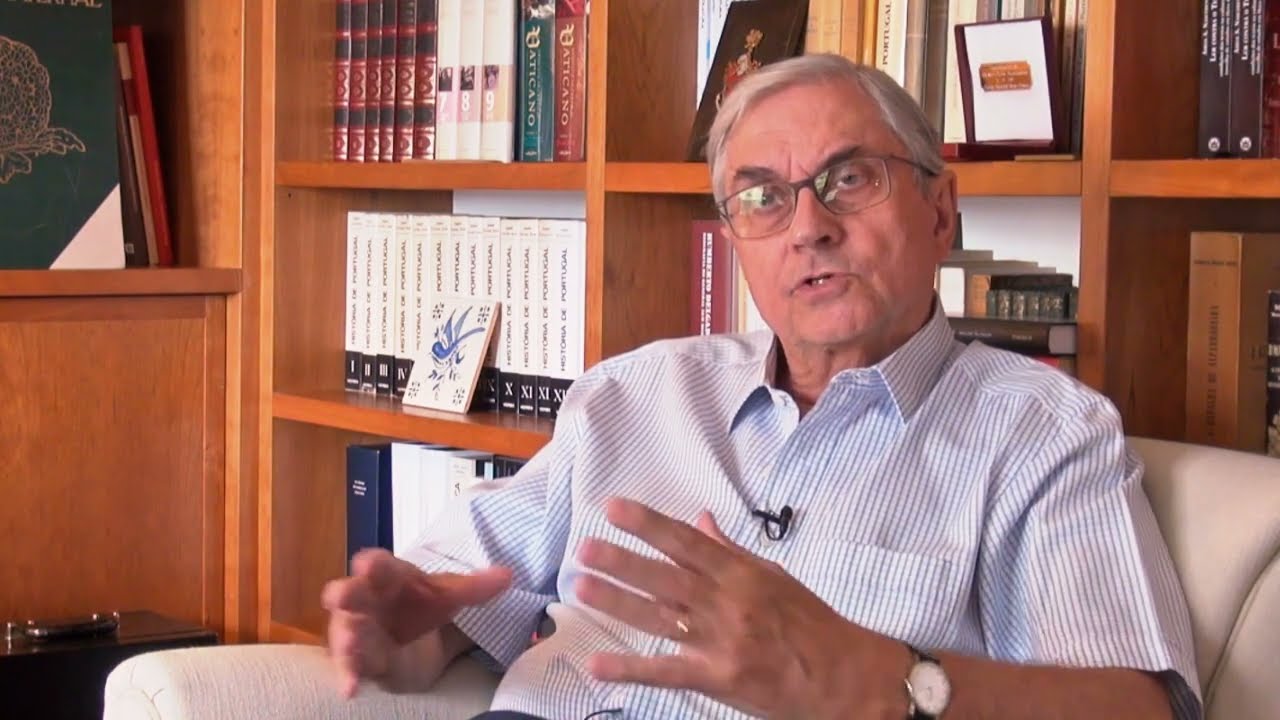

Olhando para trás, não resta margem para grandes dúvidas: "Termos ficado fora das provas PISA teria sido uma perda para o país." Quem o diz é Eduardo Marçal Grilo, ex-ministro da Educação responsável pela presença de Portugal no PISA desde o início dos testes. No final dos anos 90, a participação portuguesa foi ponderada, debatida, questionada. Que provas eram estas que a OCDE queria fazer? Para quê? E se os resultados fossem muito maus? Seria boa ideia sujeitar o país a esse "exame"? O ministro português optou por dizer "sim". E bem, continua a defender: "Penso que a decisão que foi tomada foi a decisão correta."

Quase vinte anos depois, "o PISA tornou-se um excelente aferidor, é um instrumento muito usado por todos os países, e que, na minha opinião, deve ser muito acarinhado". Aparece "como um indicador externo que as escolas devem interiorizar nas suas estratégias, nas suas próprias formas de atuar e de entender os problemas com que se debatem". Não no sentido de "trabalhar para o PISA", mas de se sentirem "mais motivadas para fazer melhor – estas avaliações permitem-nos também criar alguns incentivos".

Marçal Grilo continua a acompanhar com interesse a prestação dos alunos portugueses nas várias edições do PISA. E o que é que mais o surpreende, pela positiva? "Os nossos jovens darem muitas respostas corretas que derivam de uma capacidade para pensar. Não é propriamente o terem ou não os conhecimentos – é terem a capacidade para pensar e resolver problemas. Tenho esperança que as escolas continuem neste caminho em que estão."

A sigla nada tem que ver com a cidade italiana, antes representa as iniciais do Programme for International Student Assessment, o maior teste internacional sobre sistemas educativos, que avalia as competências dos alunos de 15 anos de países de todo o mundo. Por cá, designa-se Programa Internacional de Avaliação de Alunos; Portugal participa desde o início.

Realizam-se de três em três anos, sendo que em cada edição há um enfoque numa das três literacias testadas. Em 2000, o ano de estreia dos testes, a avaliação incidiu sobretudo sobre a literacia em leitura. Em 2003, o domínio em destaque foi a literacia matemática e em 2006 a científica. O ciclo repete-se desde então e em 2015 voltou-se à ciência e em 2018 à leitura. No entanto, são sempre divulgados resultados para as três áreas.

Na edição de 2015 foi acrescentado um domínio novo: a capacidade de resolução de problemas em conjunto com duas ou mais pessoas. E as provas passaram a ser feitas em computador. Em 2018, Portugal participou pela primeira vez no teste de literacia financeira. Um domínio do PISA que avalia o conhecimento e compreensão de conceitos financeiros, as capacidades , motivação e confiança para tomar decisões em diferentes contextos financeiros.

Os testes pretendem acima de tudo avaliar se os estudantes de 15 anos (em muitos países a escolaridade obrigatória termina quando se atinge essa idade) adquiriram os conhecimentos e as capacidades/competências que se consideram essenciais para garantir uma integração e participação bem-sucedidas na vida e no trabalho das sociedades modernas.

Pede-se aos alunos, não apenas que reproduzam o conhecimento que têm em áreas fundamentais, mas também que sejam capazes de utilizá-lo para encontrar respostas para problemas da vida real e situações com as quais não estão familiarizados. A abordagem baseia-se sobretudo na noção de que, nas economias modernas, interessa não tanto o que se sabe mas o que se consegue fazer com esse conhecimento.

A seleção das escolas participantes e dos alunos é feita, pelo consórcio internacional que trabalha com a OCDE, com base num método de amostragem aleatória por etapas. Na primeira fase, é constituída a amostra de escolas, divididas por regiões e tipologia. Na segunda fase, são identificados, nas escolas selecionadas, todos os estudantes elegíveis – jovens de 15 anos inscritos em qualquer modalidade de ensino ou formação, do 7.º ao 11.º anos (a maioria está no 9.º e no 10.º). Finalmente, são selecionados aleatoriamente cerca de 40 a 50 alunos em cada estabelecimento de ensino (em 2018 foram amostrados 5 932 estudantes de 276 escolas).

A amostra é representativa da diversidade do país e do sistema educativo. Na seleção das escolas são também tidas em conta as regiões do país e o tipo de ensino (público ou privado), bem como se a área em que se insere a escola é mais ou menos urbana. Ninguém pode pedir para ser escolhido, mas também ninguém é obrigado a participar, pois o envolvimento, quer de escolas quer de alunos, é sempre voluntário. O que a OCDE faz é estabelecer taxas de participação mínimas, de escolas e alunos.

Não. Aliás, os alunos que são selecionados para integrar a amostra nem chegam a saber como se saíram (nem tão pouco as suas escolas), sendo essa a recomendação da OCDE. Contudo, há países, como a Finlândia, que dão às escolas feedback sobre o seu desempenho. Em Portugal tal não acontece.

Para cada país é calculada uma classificação em pontos. O valor de referência foi fixado pela OCDE em 500 pontos no ciclo em que o domínio (leitura, ciências, matemática) foi o principal. A média dos países da OCDE tem variado (negativamente) ao longo dos ciclos, ainda assim, permite traçar a linha que divide os países do PISA: de um lado, os que têm resultados "positivos" (acima da média da OCDE); e do outro os que ficam abaixo.

A par dessa classificação e da percentagem de alunos em cada um dos seis níveis de proficiência, é apresentada uma parafernália de indicadores – que resultam dos questionários de contexto aplicados a diretores de escolas, professores pais e alunos.

A partir das respostas dadas nestes questionários é possível recolher uma enorme variedade de informações sobre os sistemas educativos, que vai muito além dos resultados obtidos nos testes. Por isso, e tendo em conta o número de países abrangidos pelo PISA, destes questionários resulta a maior base de dados na área - à qual se recorreu para fazer a maior parte das análises aqui apresentadas.

Não. Ao contrário do que acontece em Portugal com os exames nacionais, as provas não são conhecidas. A OCDE apenas liberta algumas questões relativas a cada uma das literacias testadas. E como os testes não incidem sobre conteúdos de disciplinas, mas sobre a capacidade dos alunos de utilizar informação, racionar e resolver problemas inspirados em situações da vida real, também não é possível treinar para as provas.

Faça aqui o teste de leitura do PISA 2018.

No final de novembro de 2016, Portugal ficou a saber que também os alunos mais novos (do 4.º ano) tinham melhorado muitíssimo a matemática, registando a maior progressão do TIMSS (Trends in International Mathematics and Science Study), comparando com todos os outros países igualmente presentes na primeira edição desta avaliação, em 1995. Se há 20 anos o país ocupava a antepenúltima posição, num total de 17 países, coloca-se agora no 13.º lugar, entre 49 Estados e regiões. Os alunos portugueses conseguiram mesmo um desempenho médio superior aos colegas da Finlândia. A ciências, o outro domínio testado no TIMSS, os resultados são bem mais modestos. Apesar da evolução positiva ao longo dos anos, o desempenho piorou em relação à última edição, em 2011.

Em dezembro de 2017, foram divulgados os desempenhos dos alunos do 4.º ano e a leitura nos testes PIRLS (Progress in InternationalReading Literacy Study). Em 2011, quando se estreou nesta avaliação, Portugal ficou na 19.ª posição, acima de Espanha e de França, por exemplo, num total de 45 participantes. Já na edição de 2016, Portugal registou uma pontuação de 528 pontos ( menos 13 pontos que em 2011) caindo para a 30.ª posição da escala ordenada dos 50 países participantes.

Em 2018, Portugal participou no ICILS ( International Computer Information Literacy Study) o primeiro estudo por amostragem de larga escala realizado no país com o objetivo de avaliar a literacia digital dos alunos a frequentar o 8.º ano de escolaridade. Portugal ficou posicionado a meio da tabela da literacia digital da lista ordenada dos 12 países que participaram na edição de 2018 e na penúltima posição em Pensamento Computacional. O ICILS revelou que em Portugal, à semelhança do que acontece noutros países, o acesso às tecnologias de informação e comunicação por si só não é suficiente para o desenvolvimento de competências avançadas de literacia digital.

Os resultados aqui apresentados baseiam-se maioritariamente nas análises feitas no âmbito do projeto aQeduto. Este projeto teve por objetivo analisar de forma mais aprofundada os dados recolhidos pelo PISA – não só os resultados dos testes em si, mas também a informação dos questionários de contexto a pais, alunos, professores e escolas – e comparar Portugal com outros países. Tendo em conta a quantidade de países onde o PISA é aplicado, surgiu a necessidade de reduzir o número de países em estudo, de forma a que este fosse mais relevante para o que se pretendia: analisar o posicionamento de Portugal relativamente a outros países.

Procedeu-se, então, a um estudo de agrupamento de países. Para isso foi selecionado um conjunto de variáveis, com impacto ao nível da estrutura do sistema educativo de cada país e que de alguma forma não se distanciassem muito da realidade de Portugal. As variáveis selecionadas foram as seguintes: desempenho médio a matemática no PISA 2012; nível económico, social e cultural dos alunos; percentagem de alunos de 15 anos que repetiram o ano pelo menos uma vez; e nível de formação dos pais. A partir desse agrupamento de países, escolheu-se um representante de cada grupo, tendo-se decidido incluir também a Polónia, por se tratar de um caso de sucesso e sistematicamente referido pelos estudos PISA.